Si sus auriculares con cancelación de ruido cancelan los sonidos que realmente preferiría escuchar, los investigadores de la Universidad de Washington pueden tener una solución que valga la pena escuchar.

El equipo de la Universidad de Washington ha desarrollado algoritmos de aprendizaje profundo que permiten a los usuarios decidir qué sonidos filtrar de un entorno y cuáles dejar entrar. Los ejemplos incluyen sentarse en un parque disfrutando del canto de los pájaros, mientras se bloquea el sonido de la gente que habla. O bloquear el zumbido de una aspiradora en casa mientras se escucha un golpe en la puerta.

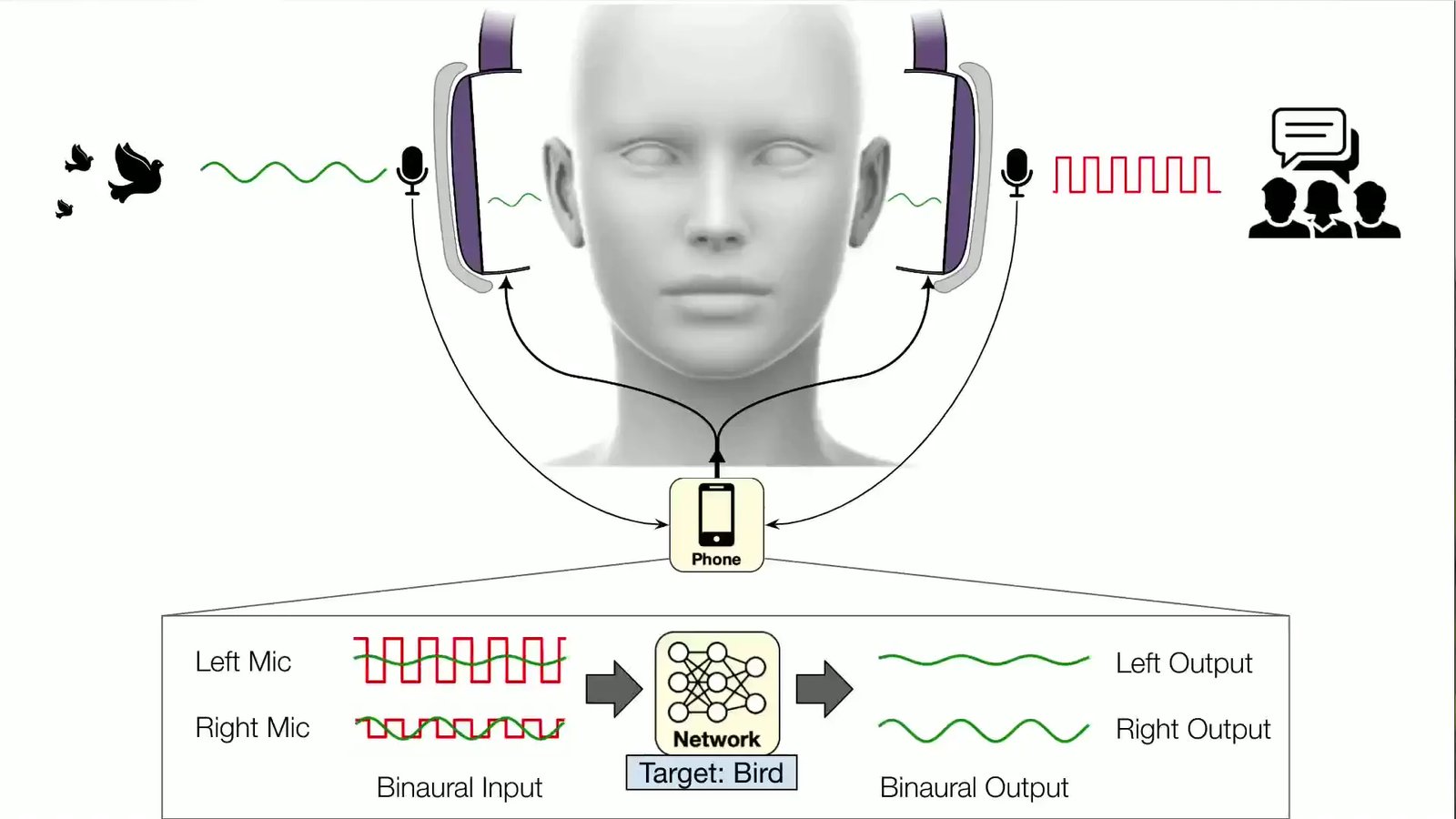

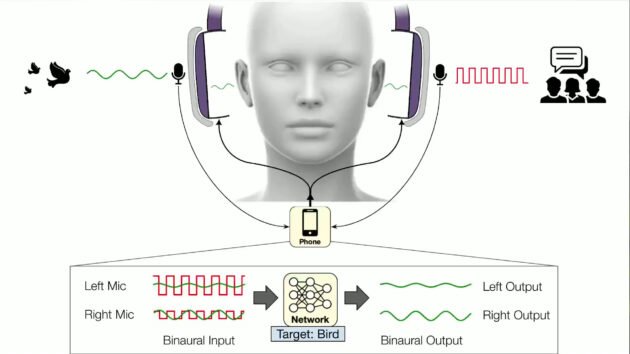

El sistema, llamado “audición semántica”, funciona con auriculares que transmiten el audio capturado a un teléfono inteligente conectado, lo que cancela todos los sonidos ambientales. A través de comandos de voz o una aplicación, un usuario selecciona sonidos de 20 clases para ingresar. Pájaros, sirenas, bebés que lloran, bocinas de automóviles: solo los seleccionados se reproducirán a través de los auriculares.

“Comprender cómo suena un pájaro y extraerlo de todos los demás sonidos de un entorno requiere inteligencia en tiempo real que los auriculares con cancelación de ruido actuales no han logrado”, dijo el autor principal. Shyam Gollakota, profesor de la Universidad de Washington en la Escuela de Ingeniería y Ciencias de la Computación Paul G. Allen. “El desafío es que los sonidos que escuchan los usuarios de auriculares deben sincronizarse con sus sentidos visuales. No puedes escuchar la voz de alguien dos segundos después de que te hable. Esto significa que los algoritmos neuronales deben procesar los sonidos en menos de una centésima de segundo”.

Esa necesidad de velocidad es la razón por la que el sistema auditivo semántico procesa sonidos en un teléfono inteligente conectado en lugar de hacerlo a través de servidores en la nube. Debido a que los sonidos de diferentes direcciones llegan a los oídos de las personas en diferentes momentos, el sistema también debe preservar los retrasos y otras señales espaciales para que las personas aún puedan percibir de manera significativa los sonidos en su entorno. según la Universidad de Washington.

Apple lanzó una nueva generación de sus auriculares inalámbricos AirPods Pro en septiembre que confiar en software mejorado para decidir de forma inteligente lo que los usuarios necesitan escuchar cuando están en modo de cancelación de ruido.

El sistema UW se probó en entornos como oficinas, calles y parques y pudo extraer sirenas, cantos de pájaros, alarmas y otros sonidos de objetivos, al tiempo que eliminaba todos los demás ruidos del mundo real.

El sistema tuvo dificultades para distinguir entre sonidos que comparten muchas propiedades, como la música vocal y el habla humana, y los investigadores dijeron que entrenar los modelos con más datos del mundo real podría mejorar esos resultados.

El equipo presentado sus hallazgos 1 de noviembre a las UIST ’23 en San Francisco. En el futuro, los investigadores planean lanzar una versión comercial del sistema.